Technische nieuwsupdate AI - April 2024

De snelheid waarmee chatbots in capaciteiten groeien is nauwelijks bij te houden. Lange tijd was GPT-4 de onbetwiste nummer één op de zogeheten Chatbot Arena Leaderboard, tót Anthropic’s op 4 maart 2024 ‘Claude 3’ introduceerde. In de Chatbot Arena kan een gebruiker een tijdje chatten met twee chatbots, zonder te weten welke chatbot het is. Vervolgens kiest de gebruiker een winnaar uit. Via een ratingsysteem dat ook bij schaken wordt gebruikt, komt Claude 3 nu op de hoogste score uit.

Omdat chatbots risico’s met zich meenemen, staan ook de ontwikkelingen om deze AI-systemen te beveiligen niet stil. Op 4 maart 2024, opvallend genoeg op dezelfde dag als de introductie van Claude 3, kwam Cloudflare met de AI Firewall, een AI-toepassing ter beveiliging van AI-chatbots.

Wat kan Claude 3 allemaal?

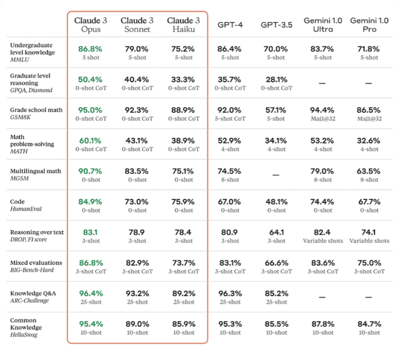

Claude 3 behaalt op verschillende gebieden betere prestaties dan GPT-4 (zie afbeelding). De sterk verhoogde contextlengte van Claude 3 speelt daarbij een belangrijke rol. Claude 3 kan op basis van veel meer context een antwoord genereren: tot 150.000 woorden tegenover GPT-4’s 25.000 woorden. Dit is vooral nuttig bij lange interacties, waar het totaal aantal woorden in de chatgeschiedenis al snel boven de 25.000 uitkomt. In dergelijke gevallen moet GPT-4 eerdere informatie inkorten, wat afbreuk doet aan de nauwkeurigheid. Claude 3 zal langer kwalitatieve antwoorden kunnen geven.

Ook haalde Claude 3 een bijna perfecte score (99%) in de ‘Needle In A Haystack’ (NIAH) evaluatie, waar taalmodellen worden gevraagd om informatie uit extreem grote datasets correct te kwalificeren. Hierdoor kan Claude 3 uit de context opmaken dat de gebruiker een grapje maakt, en kan het zelfs herkennen dat bepaalde prompts waren bedoeld om te testen of Claude 3 nog wel bij de les was. Volgens gebruikers van Claude 3 voelt het hierdoor alsof de chatbot over een soort ‘bewustzijn’ beschikt.

Ook haalde Claude 3 een bijna perfecte score (99%) in de ‘Needle In A Haystack’ (NIAH) evaluatie, waar taalmodellen worden gevraagd om informatie uit extreem grote datasets correct te kwalificeren. Hierdoor kan Claude 3 uit de context opmaken dat de gebruiker een grapje maakt, en kan het zelfs herkennen dat bepaalde prompts waren bedoeld om te testen of Claude 3 nog wel bij de les was. Volgens gebruikers van Claude 3 voelt het hierdoor alsof de chatbot over een soort ‘bewustzijn’ beschikt.

Extreem krachtige taalmodellen: leuk, nuttig, maar ook gevaarlijk

Door de verhoogde capaciteiten van chatbots ontstaan ook steeds grotere risico’s. Hoe complexer de datasets waar een chatbot mee kan werken, hoe meer deze datasets zullen worden geüpload. Deze datasets bevatten vaak zeer gevoelige informatie, die niet alleen met de chatbot zelf, maar ook met de aanbieders van de chatbots worden gedeeld. Deze aanbieders staan voor grote vuren om de gegevens te beveiligen. Recentelijk bleek dat het Amerikaanse Hugging Face, een populair hostingplatform voor AI-systemen, vatbaar was voor zogeheten ‘prompt injection’-aanvallen, cyberaanvallen waarmee AI-systemen door strategisch ingevoerde prompts kunnen worden misleid. Op die manier kunnen hackers de systemen gebruiken om gevoelige informatie op te vragen.

Ook bestaan er grotere interne risico’s, zeker wanneer kwaadwillige interne partijen, zoals ontevreden collega’s, toegang hebben tot grote datasets. Deze datasets kunnen bijvoorbeeld financiële of medische gegevens van andere werknemers bevatten, maar ook bedrijfsgeheimen of gevoelige gegevens over klanten. Door gebruik te maken van krachtige chatbots, zouden deze gegevens nu makkelijker dan ooit kunnen worden opgespoord.

Met het oog op deze risico’s moet er dus een robuust beveiligingssysteem worden ingebouwd. Dit is bij AI-systemen echter moeilijker dan bij normale applicaties, onder meer door de volgende twee redenen:

- Consistentie: Normale apps werken altijd op dezelfde manier. Als een bankapp wordt verzocht het saldo op te vragen, levert dit in principe altijd dezelfde respons Chatbots reageren in natuurlijke taal en geven niet altijd hetzelfde antwoord, zelfs als dezelfde input wordt geleverd. Dat maakt het lastig om een kwaadwillige aanval van een onschuldige prompt te onderscheiden.

- Hoe ze werken met informatie: In normale apps zijn de regels (code) en de informatie (data) van elkaar gescheiden. Er is een gelimiteerd aantal opties om toegang te krijgen tot de informatie. Maar bij chatbots wordt alle trainingsdata onderdeel van de code zelf, waardoor het vrijwel onmogelijk wordt om te bepalen welke code tot welke (kwaadaardige) informatie heeft geleid. Dat maakt het veel lastiger om een beveiligingslek te identificeren.

Cloudflare Firewall:

Dit maakt het voor bedrijven die beveiligingssoftware ontwikkelen, zoals Cloudflare, een uitdaging om een beveiligingssysteem te ontwerpen dat een AI-systeem ‘van binnenuit’ beschermt. De AI Firewall van Cloudflare, die vorige maand op de markt is gebracht, werkt daarom door riskante prompts te identificeren en te ontdoen van gevoelige gegevens vóórdat zij in het model worden opgenomen. Daarbij maakt de AI Firewall, hoe kan het ook anders, zélf ook gebruik van AI.

De firewall is ook ontworpen om de eerdergenoemde ‘prompt injection’-aanvallen te voorkomen, input die ervoor kan zorgen dat een AI-model wordt misleid om valse of gevaarlijke reacties te produceren. De firewall voegt een extra beschermingslaag toe aan de chatbot, waardoor prompts worden geblokkeerd die in vooraf bepaalde ongepaste categorieën vallen. Klanten van Cloudflare’s Firewall kunnen zelf ook categorieën toevoegen.

Conclusie

Het nieuwste Claude-taalmodel van Anthropic heeft de lat voor AI-chatbots weer aanzienlijk verhoogd. Gebruikerservaringen suggereren dat Claude 3 een dusdanig hoog niveau heeft bereikt dat het onderscheid met menselijke interactie bijna niet meer te merken is. Deze kracht roept de vraag op hoe deze systemen het best onder controle kunnen worden gehouden. Het vooraanstaande cybersecuritybedrijf Cloudflare introduceert nu een firewall om AI-chatbots mee te beveiligen. Via de AI Firewall kunnen prompts worden aangepast om de verspreiding van gevoelige gegevens te beperken, of volledig worden geblokkeerd als zij op een potentiële cyberaanval wijzen. De AI Firewall zou bedrijven kunnen helpen die intensief gebruikmaken van chatbots of chatbot-API’s, en de kans op datalekken of andere cybersecurity-problematiek willen verkleinen.

Meer van onze artikelen

-

Blog 22 April 2025

Security Privacy Artificial Intelligence Zorg Academy

Security Privacy Artificial Intelligence Zorg AcademyOpleidingen in de Digital Decade, versnellen of verdwalen?

Lees meer -

Blog 14 April 2025

Artificial Intelligence Digital Decade

Artificial Intelligence Digital DecadeSlimme technologie, roekeloos gebruik? AI en ESG in de praktijk

Lees meer -

Blog 9 April 2025

Artificial Intelligence

Artificial IntelligenceSlimmer werken met AI: hoe onze juridische prompt bibliotheek de sector vooruithelpt

Lees meer