De toekomst van AI & productiviteit: hoe ga je om met Microsoft Copilot?

Het gebruik van AI op de werkvloer is voor veel bedrijven niet meer weg te denken en met een reden. Recent onderzoek wijst uit dat werknemers die gebruik maken van ChatGPT meer taken afkrijgen, en dit ook nog eens sneller en beter doen. Het gebruik van ChatGPT is pas het begin. Met de introductie van Microsoft Copilot, dat sinds 1 November 2023 wordt uitgerold voor gebruikers van Microsoft 365 Enterprise, krijgt de AI-revolutie weer een volledig nieuwe wending.

Microsoft Copilot doet denken aan ‘Clippy’, de lachende paperclip die internetgebruikers tot 2007 hielp bij het navigeren door de 365-apps. Het verschil met Clippy, die gebruikers vooral in de weg zat, is dat Copilot wordt aangestuurd door het meest geavanceerde taalmodel van 2024, GPT-4. Copilot biedt gebruikers niet alleen simpele instructies, maar kan ook zelf taken uitvoeren. Op basis van vragen van gebruikers, kan Copilot Word-documenten samenvatten, Excel-bestanden analyseren en volledige Powerpoints opstellen.

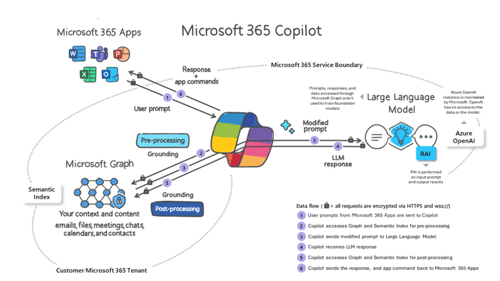

Hoe werkt Microsoft Copilot?

Het proces van vraag tot antwoord begint met een gebruiker die een vraag (vanaf nu: ‘prompt’) stelt in één van de 365-apps. Deze prompt wordt als eerst naar Microsoft Graph gestuurd. In Microsoft Graph worden alle gedeelde bestanden in 365 Enterprise (zoals Word en Powerpoint bestanden) opgeslagen. De prompt wordt naar Graph gestuurd, zodat kan worden nagegaan of de gebruiker bevoegd is om een antwoord op de prompt te krijgen. Om dat te controleren onderzoekt Microsoft Graph alle geïmplementeerde toegangsbeperkingen en compliance systemen zoals Microsoft Purview. Bij groen licht wordt bepaald dat de prompt naar het taalmodel (het LLM) mag worden gestuurd. Eerst kijkt Microsoft echter nog hoe de prompt kan worden verbeterd, zodat het LLM een nóg nuttiger antwoord kan geven. De prompt kan op vier verschillende manier worden aangevuld:

- Eerst worden relevante gegevens in Microsoft Graph aan de prompt toegevoegd. Als je bijvoorbeeld een vraag stelt over een bepaalde collega, voegt het relevante gegevens over die collega toe.

- Ten tweede wordt online (via Bing) gezocht naar extra informatie over de prompt die het LLM kan helpen om een beter antwoord te geven.

- Ten derde worden gegevens toegevoegd die de gebruiker zelf heeft aangeleverd. Dit zijn bijvoorbeeld de eerdere chats van een conversatie tussen de gebruiker en Word.

- Ten slotte wordt een ‘systeemprompt’ toegevoegd, die het LLM vertelt naar welk soort bronnen het moet zoeken en welke stijl het moet aanhouden.

Nadat de prompt volledig is aangekleed en opgedirkt, wordt het eindelijk naar het LLM gestuurd. Het LLM is de ‘motor’ van Microsoft Copilot, waar het uiteindelijke antwoord wordt gegenereerd op basis van enorme hoeveelheden data. Het LLM van Microsoft Copilot is gebaseerd op OpenAI’s GPT-4. De gegevens worden echter niet bij OpenAI opgeslagen, maar bij Microsoft Azure. Ook worden de prompts niet gebruikt om het LLM te trainen. Het LLM gebruikt de prompts alleen voor lokale data-analyse, waardoor zij binnen de 365 Enterprise omgeving blijven en niet extern worden gedeeld.

Nadat het LLM een antwoord heeft geformuleerd, wordt het antwoord nog één keer naar Microsoft Graph gestuurd, waar een laatste ethische en inhoudelijke controle plaatsvindt. Het antwoord van het LLM en de gegevens die zijn gebruikt om tot dit antwoord te komen, worden opgeslagen in Microsoft Graph.

Interne en externe beveiligingsrisico’s

Microsoft Copilot is de droom van iedereen die in korte tijd veel informatie wil genereren en analyseren. Deze kracht heeft een keerzijde: ook kwaadwillige partijen kunnen er van profiteren. Daarom heeft Microsoft verschillende maatregelen geïmplementeerd om de privacy van gebruikers te beschermen. Zo controleert Copilot of een mogelijke toegangsbeperking de gebruiker in de weg zit om antwoorden te krijgen van het taalmodel.

Ondanks dat Copilot goed beveiligd is, liggen er praktisch risico’s op de loer: alleen als toegangsbeperkingen binnen een organisatie consistent correct worden toegepast, kan de privacy van werknemers worden gewaarborgd. In de praktijk gaat de implementatie van toegangsbeperkingen niet altijd goed, zo volgt uit een rapport van Microsoft zelf. Kleine foutjes worden snel gemaakt, maar kunnen grote gevolgen hebben. Stel dat HR een map heeft gemaakt met basisinformatie van werknemers die toegankelijk is voor iedereen op kantoor. Als HR vervolgens onbedoeld een bestand met salarisgegevens aan deze map toevoegt, zijn ook deze uiterst gevoelige gegevens plots voor iedereen te zien.

Normaal gesproken hoeven dergelijke menselijke fouten niet altijd tot problemen te leiden. Het afstruinen van gedeelde documenten om naar gevoelige informatie te zoeken, is immers nog niet zo’n eenvoudige taak. Door de introductie van Copilot eroderen deze praktische obstakels. Een kwaadwillige collega zou nu simpelweg kunnen vragen: “hoe veel verdient collega X eigenlijk?” om deze informatie te achterhalen. Dit is het belangrijkste interne risico.

Dit interne risico kan vervolgens ook een extern risico worden. Niet ondenkbaar is bijvoorbeeld dat ontevreden werknemers deze gevoelige informatie over collega’s, cliënten of het kantoor opslaan op een persoonlijke locatie, die kwetsbaar is voor beveiligingsinbreuken. Ook kunnen ze de gegevens met andere onbevoegden delen, waaronder mensen buiten het bedrijf.

Dergelijke incidenten kunnen worden gekwalificeerd als datalekken, die onderhevig zijn aan een meldplicht en gepaard gaan met reputatieschade en flinke boetes. Datalekken kunnen beter worden voorkomen, omdat zij moeilijk zijn te genezen. Om dat te bereiken moeten werknemers geïnformeerd worden over de correcte omgang met vertrouwelijke documenten en toegangscontrolesystemen. Daar kan een praktische invulling aan worden gegeven door een helder intern personeelsbeleid op te stellen. Een eerste stap daarbij is het identificeren van gevoelige documenten. Het is belangrijk om een duidelijke definitie te hebben van gevoelige data zodat werknemers meteen weten welke gegevens extra bescherming nodig hebben. Vervolgens is het belangrijk om in kaart te brengen wat er met deze gegevens gebeurt. Waar worden deze documenten opgeslagen en hoe worden zij beveiligd? Tenslotte moeten adequate regels om deze gegevens te delen worden opgesteld. ICTRecht kan u helpen bij het opstellen van een volledig beleid.

Ook is er een verhoogd intern en extern risico, doordat de impact van elke beveiligingsinbreuk hoger is. Een kwaadwillige partij kan op een computer met Copilot veel sneller grote hoeveelheden gevoelige gegevens verzamelen, door tactische prompts in te voeren, zoals “maak een samenvatting van mijn inbox”. Hierdoor kan het kwaad al geschied zijn, zelfs als de cyberaanval binnen korte tijd is gedetecteerd en de aanvaller al na enkele minuten uit het systeem is gezet. Dit risico benadrukt het belang om de beveiligingssystemen van alle computers op kantoor op het hoogste niveau te houden. Onze experts bij security kunnen u hier in bijstaan.

Privacy risico’s toepassingen Microsoft Copilot

Ook moet voorzichtig worden omgesprongen met de toepassingen van Copilot zelf. Zo biedt Copilot in Microsoft Teams gebruikers de mogelijkheid om informatie over de bijeenkomst op te vragen, zelfs als ze later deelnemen of volledig afwezig waren. Dit wordt mogelijk gemaakt door real-time transcriptie van de meeting, waarbij Copilot zelfs kan identificeren wie wat heeft gezegd. Ook kan Copilot worden gevraagd om deepfakes te genereren. Dat kan leuk zijn als je een foto van een lachende groep collega’s wil gebruiken voor een uitnodiging. Hoewel deze deepfake gepaard zal gaan met een watermerk waaruit blijkt dat het niet gaat om een echte foto, zullen niet alle collega’s op dergelijke foto’s zitten te wachten.

Veel van de functies kunnen in Copilot worden uitgeschakeld. Als er voor een transparante en bewuste omgang met Copilot wordt gezorgd, hoeven deze functionaliteiten echter niet uit te worden geschakeld om de privacy van werknemers te beschermen. Werknemers moeten weten welke persoonlijke gegevens verzameld worden, hoe lang zij worden bewaard en hoe zij tegen deze verwerking kunnen optreden. Verder kan een beleid worden opgesteld waardoor werknemers zich bewust worden van welke privacyrisico’s aan welke prompts zijn verbonden.

Conclusie

Terwijl Microsoft Copilot ongekende mogelijkheden biedt voor productiviteitsverhoging en innovatie op de werkplek, gaat het ook gepaard met de verhoging van verschillende privacy-risico’s. Zorg daarom voor goed beveiligde systemen, een strikte handhaving van toegangsbeperkingen en een werkomgeving waar men bewust is van de privacyrisico’s. ICTRecht kan u daarbij helpen. Op die manier kan uw organisatie op een privacy-vriendelijke manier profiteren van de enorme potentie van Microsoft Copilot.

Wil je op een goede en verantwoorde manier omgaan met de mogelijkheden van Microsoft Copilot, dan adviseren wij om Copilot Studio te gebruiken. Dit is ook de omgeving waarin onze AI-kennisassistent Luka is opgezet. Het voordeel hiervan is dat de gegevens binnen de eigen omgeving blijven en de bot naar eigen inzicht en op basis van eigen bronnen is in te richten. Daarnaast is het met Copilot Studio mogelijk om workflows in te stellen die verschillen onderdelen van Microsoft met elkaar laat communiceren.

Meer weten over onze AI-kennisassistent Luka?

Bekijk dan onze website of neem direct contact op.

Meer van onze artikelen

-

Blog 15 April 2025

Academy

AcademyFG, DPO, (C)ISO, PO: wie is wie?

Lees meer -

Blog 14 April 2025

Artificial Intelligence Digital Decade

Artificial Intelligence Digital DecadeSlimme technologie, roekeloos gebruik? AI en ESG in de praktijk

Lees meer -

Blog 10 April 2025

Zorg

ZorgEHDS in de praktijk: hoe verandert de gegevensuitwisseling bij een zorginstelling?

Lees meer