De AI Act is er - maar wanneer valt een AI eronder?

Afgelopen maandag lekte de definitieve tekst uit van wat de AI Act moet worden. Formeel moet er nog worden gestemd, maar gezien het politiek akkoord uit december is er maar één uitkomst mogelijk: die Act komt er. Laten we eens kijken naar wat de wet betekent voor de praktijk, beginnend bij de belangrijkste vraag voor mensen die AI ontwikkelen of inzetten – val ik onder de AI Act met dit systeem?

Definitie van AI

De focus van de AI Act is op systemen en toepassingen. De definitie van AI is dan ook geschreven als die van een systeem:

An AI system is a machine-based system designed to operate with varying levels of autonomy and that may exhibit adaptiveness after deployment and that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments.

In eerdere versies werd in deze definitie nog verwezen naar gebruik van allerlei technieken, zoals neurale netwerken of expertsystemen. Dat is allemaal verlaten; waar het bij AI echt om gaat, is dat we systemen autonoom laten beslissen. Het gebrek aan menselijke tussenkomst of toezicht is waar de risico’s door ontstaan, en dus zijn systemen in principe AI wanneer ze autonoom opereren.

Inference oftewel afleiding

In principe, want er is meer: de systemen moeten bepaalde doelen (objectives) gesteld zijn en zelfstandig achterhalen hoe daarbinnen uitvoer te genereren zoals voorspellingen, content of aanbevelingen. De doelen kunnen expliciet zijn, zoals bij een ChatGPT-prompt, of meer impliciet zoals bij een systeem dat objecten in beeld classificeert zonder precies te weten waarom. Overweging 6 van de AI Act legt uit: “The techniques that enable inference while building an AI system include machine learning approaches that learn from data how to achieve certain objectives; and logic- and knowledge-based approaches that infer from encoded knowledge or symbolic representation of the task to be solved.” Het gaat er dus om dat het systeem zelfstandig afleidt wat er moet gebeuren.

De definitie is afkomstig van de internationale OECD, die nog tijdens de onderhandelingen over de AI Act een en ander aanscherpte om beter aan te sluiten bij de praktijk van vandaag. De formulering is iets aangepast zodat het één zin is, wat voor juridische toepassingen gebruikelijk is.

Voorbeelden van AI of niet

Ik pak er wat voorbeelden bij:

- Een chatbot voor klantenservice die natuurlijke taalverwerking gebruikt om vragen van klanten te begrijpen en passende antwoorden te genereren. Dit valt onder de definitie, omdat het autonoom opereert en zelfstandig uitvoer genereert (zoals antwoorden en aanbevelingen) binnen impliciete doelstellingen (de klant helpen).

- Een irrigatiesysteem in de tuin dat de grondvochtigheid en omgevingstemperatuur meet en via een opgegeven formule autonoom bepaalt hoe veel water toegevoegd moet worden. Hoewel dit autonoom opereert, valt het niet onder de definitie, omdat er geen sprake is van ‘afleiden’ (inference) van hoe de uitvoer te maken op basis van invoer. De regels zijn vast: bij 20 graden en een grondvochtigheid van 5% zal 0,2 liter water worden toegevoegd, punt.

- Een systeem dat via machine learning getraind is om medische beelden te analyseren om ziekten te diagnosticeren. Dit systeem genereert uitvoer op basis van zelf afgeleide regels (dit is immers inherent aan machine learning). Het proces gebeurt autonoom, men drukt op de knop en krijgt de analyse. Dit is dus een AI-systeem, ook al is het autonoom handelen niet meer dan de behandelend arts wijzen op symptomen op het beeld.

- Een sleutelkaartsysteem voor gebouwtoegang is geprogrammeerd om een bezoeker op basis van autorisaties op de kaart toegang te geven tot bepaalde ruimtes maar niet tot andere. Net als het irrigatiesysteem is dit geen AI. De uitvoer is weliswaar een beslissing die autonoom genomen is, maar het sleutelkaartsysteem werkt op basis van eenvoudige, vooraf gedefinieerde regels die door mensen zijn ingesteld, zonder daarvan af te wijken of zich aan te passen aan nieuwe situaties.

- Een muziekstreamingdienst die nieuwe liedjes voorstelt op basis van luistergeschiedenis (metadata) en sonische kenmerken van andere muziek. Dit systeem handelt autonoom en doet aanbevelingen. Twijfelachtig is of sprake is van ‘inference’. Gebruik van sonische kenmerk (lied A lijkt op lied B) zou je kunnen zien als een vorm van afleiden van wat bij lied A past, maar of dat genoeg is? Is het slechts een oppervlakkige vergelijking of impliceert het een dieper begrip van muzikale voorkeuren?

Aan de definitie voldoen is één, maar dat wil niet automatisch zeggen dat de gehele AI Act van toepassing is. Juristen hanteren hierbij de termen ‘geografische’ en ‘materiële’ toepassing. Wat wil dat nu zeggen?

Wanneer valt een organisatie geografisch onder de AI Act?

Onder geografische toepasselijkheid verstaan juristen de vraag of een wet van toepassing is bezien vanuit je plaats van vestiging of handelen. Dit staat los van de vraag of wat je doet onder de wet valt. Dat laatste noemen we ‘materiële’ toepassing, en daarover gaat de volgende sectie. Maar eerst eens kijken wanneer je locatie van belang is.

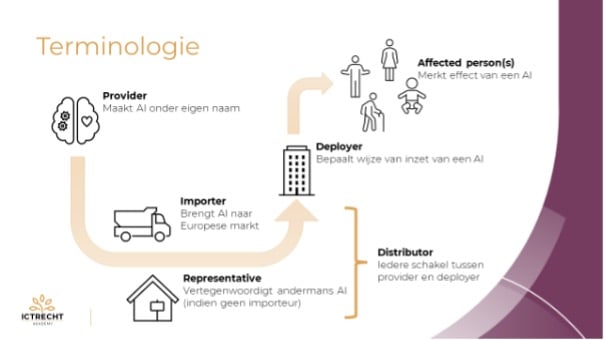

Terminologie

Om de vraag over geografische toepasselijkheid te beantwoorden, is het goed eerst een paar termen op te noemen:

- Een ‘provider’ is de entiteit die een AI-systeem ontwikkelt en onder een eigen (merk)naam op de markt brengt. Dit kan een zelfgemaakte AI zijn of ingekocht, en geldt ook bij partijen die open source AI maken.

- AI Act artikel 3 lid 2: ‘provider’ means a natural or legal person, public authority, agency or other body that develops an AI system or a general purpose AI model or that has an AI system or a general purpose AI model developed and places them on the market or puts the system into service under its own name or trademark, whether for payment or free of charge;

- Een ‘deployer’ of inzetter is een entiteit die een AI systeem inzet voor eigen doeleinden. In het Nederlands zou ‘gebruiker’ een betere term zijn, maar die term kan ook verwijzen naar een persoon die de dienst afneemt, wat juist het tegenovergestelde is van de deployer.

- AI Act artikel 3 lid 4: ‘deployer’ means any natural or legal person, public authority, agency or other body using an AI system under its authority except where the AI system is used in the course of a personal non-professional activity;

- Een ‘importer’ of importeur is een entiteit die een AI systeem van buiten de EU introduceert op de Europese markt. Dit kan zowel gebeuren door producten te importeren als door een dienst te wederverkopen.

- AI Act artikel 3 lid 6: ‘importer’ means any natural or legal person located or established in the Union that places on the market an AI system that bears the name or trademark of a natural or legal person established outside the Union;

- Een ‘distributor’ of distributeur is iedere schakel tussen provider en deployer anders dan de importeur.

- AI Act artikel 3 lid 7: ‘distributor’ means any natural or legal person in the supply chain, other than the provider or the importer, that makes an AI system available on the Union market;

Onderstaande figuur illustreert de belangrijkste begrippen en hun onderlinge relatie:

Geografische scope

Nu kunnen we de geografische scope van de AI Act beter duiden. Artikel 2 werkt in lid 1 zeven situaties uit waarin een entiteit onder de AI Act valt (de nummering moet nog worden gefinaliseerd):

- providers placing on the market or putting into service AI systems or placing on the market general- purpose AI models in the Union, irrespective of whether those providers are established or who are located within the Union or in a third country;

- deployers of AI systems that have their place of establishment or who are located within the Union;

- providers and deployers of AI systems that have their place of establishment or who are located in a third country, where the output produced by the system is used in the Union;

- importers and distributors of AI systems;

- product manufacturers placing on the market or putting into service an AI system together with their product and under their own name or trademark;

- authorised representatives of providers, which are not established in the Union.

- affected persons that are located in the Union.

De eerste is simpel genoeg: iedere provider die een AI-systeem in de EU op de markt brengt, of dat nu in een product is of als dienst (zoals een SaaS dienst). Waar de provider gevestigd is, is dan niet relevant. Wanneer je iets “op de markt” brengt, wordt bepaald door te kijken naar zaken als waar je reclame maakt, of je een Europese betaalmethode gebruikt, of je op je website expliciet op Europa gerichte toezeggingen doet, enzovoorts.

De tweede is ook rechttoe rechtaan: iedere deployer van AI die zelf in de EU gevestigd is. Een bedrijf uit Duitsland dat AI inzet om personeelsdossiers van haar medewerkers te screenen is een standaardvoorbeeld. Het maakt daarbij niet uit of het bedrijf de Duitse medewerkers screent of die uit zeg Zuid-Korea, het gaat erom dat het bedrijf in de EU gevestigd is. Of eigenlijk iets uitgebreider: ook IJsland, Noorwegen en Liechtenstein zijn relevant – die landen vormen wat juristen de EER noemen.

De derde situatie is bedoeld tegen loopholes. Wanneer een provider of deployer zelf buiten de EU gevestigd is maar de uitvoer van de AI gebruikt wordt in de EU, dan is de AI Act desondanks van toepassing. Een Nederlands bedrijf zou klantdata naar een organisatie in India kunnen sturen om klantretentievoorspellingen (‘churn’) te doen, en de resultaten gebruiken om gerichte marketing te doen. De AI wordt dan in India ingezet, maar omdat de uitvoer in de EU wordt gebruikt, vallen beide bedrijven onder de AI Act.

De vierde situatie is weer simpel: iedere importeur en Europese distributeur van AI-systeem. De vijfde situatie verwijst naar “productfabrikanten”, een EU-vakterm die grote overlap heeft met de “provider”. Deze valt onder dezelfde situatie onder de wet. En voor beiden geldt: als zij buiten de EU opereren maar wel zich richten op de EU, dan moeten zij een vertegenwoordiger stellen. Die valt op zich dan ook weer onder de AI Act.

Als laatste hebben we nog de restcategorie: “affected persons” oftewel personen die worden geraakt door AI. Als deze personen bestaan, kunnen zij zich beroepen op hun rechten en bescherming uit de AI Act.

Risico’s en systemen onder de AI Act: de GPAI

Met de definitie van AI en de geografische scope duidelijk is de toepasselijkheid van de AI Act in principe vast te stellen. Om te bepalen wat dat betekent, moeten we wel eerst kijken naar het soort systeem en de risico’s die het met zich meebrengt. Alleen zit daar nog een voorvraag aan: is sprake van een ‘AI-systeem’ of van een ‘general-purpose’ AI?

Van systeem naar general purpose

De oorspronkelijke opzet van de AI Act was eenvoudig. AI systemen die aan de definitie voldoen, en ingezet worden binnen de geografische scope, vallen onder de wet. Afhankelijk van het risiconiveau gelden dan lichte of zware eisen of geldt zelfs een volledig verbod. Maar door last-minute toevoegingen is daar nog de vraag bijgekomen of het AI-systeem general-purpose is oftewel voor “algemeen gebruik”. Ik ga dat vanaf nu GPAI noemen want andere termen zijn te lang. De AI Act legt het zo uit in definitie 44b:

‘general purpose AI model’ means an AI model, including when trained with a large amount of data using self-supervision at scale, that displays significant generality and is capable to competently perform a wide range of distinct tasks regardless of the way the model is placed on the market and that can be integrated into a variety of downstream systems or applications. This does not cover AI models that are used before release on the market for research, development and prototyping activities.'

Bekende GPAI’s zijn de grote taalmodellen zoals GPT-3 (van OpenAI) en BERT (van Google), maar ook beeldgeneratiesystemen zoals DALL-E (wederom OpenAI) en Stable Diffusion (de technologie achter Midjourney) voldoen aan deze definitie. De stormachtige opkomst van met name de AI-systemen ChatGPT en Midjourney heeft ervoor gezorgd dat hier een aparte sectie in de AI Act voor ingericht werd. Dat gaf dan weer heftige onderhandelingen, omdat ook de Europese markt de nodige GPAI providers kent, zoals het Franse Mistral dat naar verluid zware druk op haar regering zou hebben uitgeoefend om deze sectie af te zwakken.

De regels voor GPAI

De AI Act kent een aparte titel voor general-purpose AI oftewel GPAI: titel VIIIA, in de huidige tekst verwarrend genoeg opgenomen tussen Titel IV (transparantie) en Titel V (Sandboxes), maar dat zal nog aangepast worden. Maar de kern is dat een GPAI zwaar wordt gereguleerd als deze ‘systeemrisicos’ kent. Dit is het geval als het systeem een cumulatieve hoeveelheid rekenkracht gebruikt voor zijn training, gemeten in floating point operaties (FLOPs), die groter is dan 10^25.

FLOPS staat voor het aantal bewerkingen dat een computer per seconde kan uitvoeren. De waarde van 10^25 verwijst naar de kracht van de supercomputer waarop een model is getraind, evenals de duur van die training. Dit geeft dus aan hoeveel brute rekenkracht er in het trainingsproces is gestoken. De huidige top van GPAI zit rond de 10^24 FLOPs, zodat er momenteel geen GPAI zijn die daadwerkelijk als systeemrisico worden aangemerkt. De Commissie heeft echter de bevoegdheid om ook los van dit FLOP getal een GPAI als systeemrisico aan te merken, als zij daarbij de criteria uit Annex IXc gebruikt. Dit is een van de manieren waarop de weerstand uit de AI-industrie is meegenomen: die criteria moeten nader worden uitgewerkt en daarbij zal inspraak uit diezelfde industie zwaar wegen.

Alle producenten van GPAI, dus ongeacht of het een systemisch risico bevat, moeten bepaalde documentatie (artikel 52c) aanmaken en publiceren. Controversieel hierbij is bijvoorbeeld de documentatie over auteursrechten bij de trainingsdata, waarover een andere keer meer. Bij GPAI met systemische risico’s moeten daarnaast modelevaluaties en risicoanalyses uitvoeren om deze risico’s te minimaliseren.

Maar wat zijn dan ‘systemische risico’s of systeemrisico’s? De AI Act schetst (overweging 60m) een set heel algemene gebeurtenissen:

any actual or reasonably foreseeable negative effects in relation to major accidents, disruptions of critical sectors and serious consequences to public health and safety; any actual or reasonably foreseeable negative effects on democratic processes, public and economic security; the dissemination of illegal, false, or discriminatory content.

Kort en goed komt het neer op grootschalige verstoringen of schade aan basisprocessen of -behoeftes uit de maatschappij. Een autonome auto die bij winterweer massaal botst omdat de AI niet om kan gaan met sneeuw zou een voorbeeld zijn, maar ook AI die eenvoudig ingezet kan worden om verkiezingen te manipuleren of onherkenbare fake news kan genereren kan als dergelijke risicocategorie worden aangemerkt. Een systeem dat als zodanig aangemerkt is, mag op de markt blijven maar zal door de EU van duidelijke waarschuwingen worden voorzien.

Een GPAI is zo bijzonder omdat het geen specifieke toepassing kent. Per definitie kunnen zij immers een “wide range of distinct tasks” uitvoeren. Dat past niet goed bij de risicogebaseerde regulering die de AI Act voorstaat. Vandaar dat de eisen bij GPAI vooral administratief van aard zijn: vastleggen wat het systeem kan, waar de trainingsdata vandaan kan en alleen bij algemene risico’s in actie komen.

De risicoanalyse voor AI-systemen

Wie een GPAI inzet voor een specifiek doel, komt wél de volledige AI Act tegen. Bij zo’n specifiek doel – een use case in het jargon – kunnen zich concretere risico’s voordoen, en dat is waar de AI Act op gericht is. De AI Act kent daarbij drie risiconiveaus: onacceptabel, hoog en laag.

Verboden AI

Een AI is onacceptabel als deze in strijd handelt met Europese fundamentele normen en waarden, dan mag deze niet op de Europese markt ingezet worden. Een voorbeeld is predictive policing; AI laten voorspellen of iemand crimineel gedrag zal gaan vertonen. Maar ook emotieherkenning op de werkplek staat op de ‘verboden’ lijst van artikel 5. Dit vanwege de grote kans op verkeerde uitkomsten en discriminatie.

Complexer ligt het met biometrie. Over dit onderwerp is veel politieke discussie geweest, omdat biometrische herkenning gekoppeld aan handelen door AI als zeer riskant wordt gezien. Zie bijvoorbeeld wat Bits of Freedom zegt over dit onderwerp. Uiteindelijk is er uitsluitend een keihard verbod opgenomen op biometrische analyse om bijzondere persoonsgegevens (etnische afkomst, politieke voorkeur, religie, seksuele gerichtheid) te achterhalen. Er is ook een verbod op realtime biometrie op afstand voor politiediensten, maar dat kan worden gepasseerd bij specifieke zoektochten naar vermiste personen of slachtoffers van mensenhandel, het handelen bij een directe bedreiging of het zoeken naar een verdachte van een ernstig misdrijf.

Laag en hoog risico

Helemaal tegenover de verboden AI staat de laagrisico-AI: denk aan chatbots bij webwinkels of simpele plaatjesgeneratoren. Deze moeten transparant zijn over hun status als AI en mogen niet betrokken zijn bij besluitvorming (artikel 52), maar krijgen verder geen verplichtingen. Of nou ja eentje: generatieve AI die ‘synthetische’ tekst, afbeeldingen, audio of video maakt moet deze markeren:

Providers of AI systems, including GPAI systems, generating synthetic audio, image, video or text content, shall ensure the outputs of the AI system are marked in a machinereadable format and detectable as artificially generated or manipulated.

Bij dergelijke markeringen moet je denken aan al dan niet zichtbare watermerken. Deze zijn nu nog niet echt in gebruik, en het is natuurlijk de vraag hoe effectief dit werkelijk gaat zijn. Maar gezien de enorme vlucht die deepfakes en nepnieuws op basis van AI ondertussen genomen heeft, is dit zeker een stap in de goede richting.

De meeste eisen gaan gelden voor AI-systemen die een hoog risico vormen voor de gezondheid, veiligheid, grondrechten of het milieu. Zo moet duidelijk zijn waar de data vandaan komt waarmee de AI is getraind, is menselijk toezicht vereist en moet de technische documentatie op orde zijn. Het afhandelen van verzekeringsclaims, bepaalde medische hulpmiddelen en algoritmes die sollicitanten beoordelen zijn voorbeelden van hoog risico-AI.

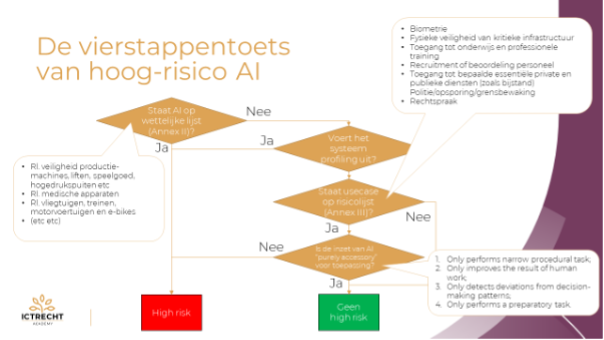

Bepaling hoogrisico-status

De AI Act kent een uitgebreid stappenplan om te bepalen of een systeem hoog risico is. Deze is geïllustreerd in onderstaand schema.

De eerste trap is de vraag of het systeem een veiligheidscomponent is van een bij wet gereguleerd product. In een bijlage (bijlage II) van de AI Act staan alle betreffende Richtlijnen en Verordeningen genoemd. Een AI die bepaalt of de lift dicht moet, is bijvoorbeeld hierom hoog risico; liften zijn gereguleerd en de deur dicht doen is een veiligheidscomponent. Een leuk liedje kiezen voor de passagiers is dan weer geen veiligheidscomponent.

Als de toepassing geen veiligheidscomponent is van zo’n gereguleerde technologie of product, dan komen we bij de ingewikkelde afweging trap: de risicolijst van bijlage III. Deze noemt acht categorieën en omschrijft daarbinnen een aantal specifieke toepassingen die als hoog risico worden gezien. De belangrijkste categorieën zijn de fysieke veiligheid van kritieke infrastructuur, toegang tot onderwijs, recruitment, toegang tot publieke diensten en verzekeringsrisico-assessments. Maar let op: niet alle inzet van AI in onderwijs is dus hoog risico, het gaat om de onder dit kopje genoemde specifieke toepassingen.

Toepassingen die niet op de lijst staan, zijn dus per definitie géén hoog risico, ook al zouden er enorme risico’s denkbaar zijn. De Europese Commissie mag toepassingen toevoegen aan de lijst, maar dat moet duidelijk gemotiveerd worden en gebeuren via een speciale procedure waar onder meer het horen van vooraf geselecteerde AI-experts hoort.

Een paar voorbeelden van toepassingen die wel of niet hoog-risico zijn:

- Een AI screent essays van studenten die toegang willen tot een master voor excellente studenten. Dit valt onder toegang tot onderwijs en wel de specifieke toepassing “determine access or admission or to assign natural persons to educational and vocational training institutions”. Daarom is de toepassing hoogrisico.

- Een AI screent essays van studenten op plagiaat. Weliswaar valt dit onder toegang tot onderwijs, maar deze specifieke toepassing binnen dat onderwerp is niet genoemd en is dus geen hoog risico.

- Een AI evalueert afval dat in een ondergrondse container wordt geplaatst, en geeft boetes wanneer het afval in een andere container had gemoeten. Dit betreft weliswaar toegang tot publieke diensten, maar de specifieke toepassing is te beperkte geformuleerd. De tekst daarvan is immers: “evaluate the eligibility of natural persons for essential public assistance benefits and services, including healthcare services, as well as to grant, reduce, revoke, or reclaim such benefits and services.” Weliswaar is afval een “essential service” maar deze dienst wordt niet geweigerd.

Maar voordat we daar zijn is er een simpele tussentoets: is sprake van profileren, het maken van inschattingen van mensen zoals we dat ook kennen uit de AVG? Zo ja, dan is de toepassing automatisch en zonder discussie hoog risico. Verstandig is dus om éérst te kijken of sprake is van profileren en pas daarna de lijst van Annex III na te lopen.

Uitzonderingen

Valt een toepassing binnen een genoemd toepassingsgebied, dan is de toepassing in principe AI. Er zijn echter vier uitzonderingen toegevoegd, die maken dat een AI in zo’n risicogebied toch weer geen hoog risico bevat. Als aan een van deze vier is voldaan, dan is de AI kort gezegd slechts een randzaak en is het gerechtvaardigd dat deze buiten de zware regels valt.

De vier uitzonderingen zijn:

- De AI voert slechts een beperkte, specifieke procedurele taak uit. Denk aan het structureren van een vragenlijst, het categoriseren van binnenkomende data of het herkennen van duplicaten bij inzendingen.

- De AI verhoogt alleen de kwaliteit van het werk, zoals door aantekeningen op te werken tot een formele brief, vergelijkbare gevallen aan te dragen of de leesbaarheid te verbeteren.

- De AI detecteert afwijkingen van gebruikelijke “beslispatronen”, zoals het signaleren dat in dit soort zaken meestal A wordt besloten en dat nu ineens B gekozen is, waarna de mens een dubbelcheck kan geven.

- De AI verricht alleen een voorbereidende taak, zoals procesbegeleiding bij een intake, het analyseren of opschonen van teksten, het vertalen van invoer, suggesties toevoegen of de kwaliteit van invoer controleren. Ook een AI die tekstsuggesties doet bij het schrijven van een beslissing, valt binnen deze uitzondering.

De Europese Commissie heeft de taak gekregen om een lijst met voorbeelden te maken van AI-systemen die wel of niet hoog risico zijn en de reden(en) waarom dat het geval is.

Verplichtingen voor hoog-risico AI

Als een AI-systeem telt als hoog risico, dan moet het volgende geregeld zijn:

- Fundamental Rights Impact Assessment: vooraf moeten gestructureerd de risico’s in kaart worden gebracht voor kwesties als veiligheid, privacy, discriminatie, eerlijke toegang tot zorg, onderwijs en belangrijke diensten.

- Risicomanagementsysteem: om potentiële risico's te identificeren, evalueren, beheren en verminderen.

- Systeem voor gegevensbeheer: er moet gebruik worden gemaakt van onbevooroordeelde, kwalitatieve en representatieve datasets.

- Technische documentatie: voor gebruikers moet duidelijk zijn hoe het AI-systeem gebruikt moet worden.

- Transparantie: voor gebruikers moet duidelijk zijn hoe het AI-systeem werkt. Zo geldt er ook een verplichting om te loggen om te kunnen traceren en controleren wat er precies is gebeurd.

- Menselijk toezicht: bij het gebruik van het AI-systeem is menselijk toezicht vereist.

- Conformiteitsbeoordeling: er geldt een specifieke conformiteitsbeoordelingsprocedure die verschilt van het huidige CE-markeringssysteem voor andere producten. Het doel is om een beoordelingsproces te hebben dat is afgestemd op de unieke kenmerken en risico's van AI-systemen.

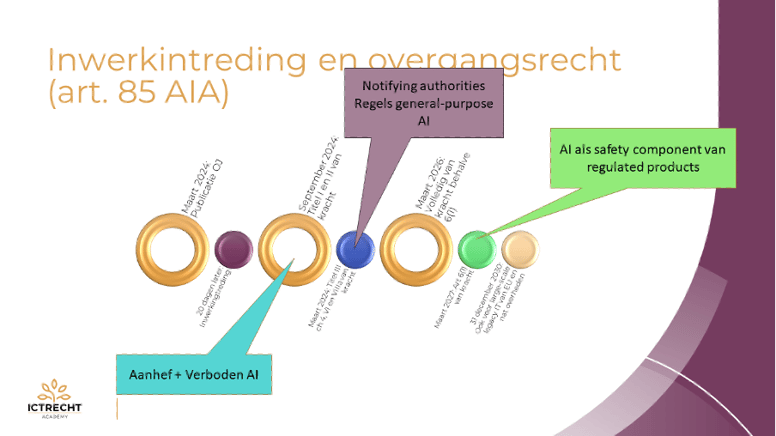

Wanneer is de AI Act van kracht?

Als laatste moeten we nog even kijken naar het tijdspad van inwerkingtreding. Dit is nogal complex. De hoofdregel is simpel: 20 dagen nadat de wet in het Official Journal van de EU is gepubliceerd, wordt deze van kracht. Maar er zijn vele uitzonderingen en overgangsregelingen opgenomen. Deze illustreren we met de tijdlijn hieronder.

Het streven is om in maart dit jaar die publicatie te doen. Daarna treden de diverse bepalingen getrapt in werking. Het verbod op de onacceptabele AI zal zes maande later, oftewel in september van kracht worden, en dergelijke systemen moeten dus dan van de markt zijn.

Over een jaar zullen de zogeheten notifying authorities aangewezen moeten zijn, die de conformiteitsassessment van hoogrisico-AI gaan uitvoeren. Deze moeten dan ook de procedures klaar hebben om dergelijke AI – die meestal in producten met CE-logo zit – te kunnen evalueren, dus dat wordt nog krap. Ook gaan over een jaar de regels voor GPAI gelden, omdat ontwikkelaars van AI-systemen vaak rekenen op GPAI als basis en dus moeten weten welke zij kunnen gaan bouwen.

In maart 2026 – dus over twee jaar – wordt vrijwel de gehele AI Act van kracht. De meest opmerkelijke uitzondering is artikel 6 lid 1, dit zijn AI-systemen die hoogrisico zijn omdat ze een veiligheidstoepassing zijn van een gereguleerd product (stap 1 uit de vierstappentoets hierboven). De fabrikanten hiervan hebben meer tijd nodig, en krijgen van de wetgever een jaar extra. En nóg weer later (2030!) moeten legacy systemen van de overheid (zoals voor grensbewaking) eindelijk voldoen aan de AI Act.

Direct aan de slag

Werk jij of werkt jouw organisatie met AI of algoritmes of overweeg je dat te doen? Neem dan nu alvast de volgende stappen:

- Inventariseer om welke AI het gaat, van welke leveranciers deze afkomstig zijn en welke informatie je van de leveranciers nodig hebt. Vergeet ook de shadow-IT niet: de AI-diensten die werknemers op eigen houtje hebben afgenomen, al dan niet als experiment.

- Onderzoek welke rol je hebt en welke verantwoordelijkheden daarbij horen. Beoordeel vervolgens of je contracten daarop aansluiten. Denk aan aansprakelijkheid, opzegtermijn en mogelijkheden om documentatie op te eisen over werking, dataset en dergelijke.

- Evalueer de uitvoer van het AI-systeem. Zorg voor protocollen voor de evaluatie van de uitvoer en maak beleid met betrekking tot periodieke controles op de juistheid van de aanbevelingen.

- Concludeer welke menselijke bemoeienis met deze AI-systemen er is binnen jouw organisatie is.

- Bepaal de risico categorie van het AI-systeem. Zie hiervoor het kopje hierboven “Bepaling hoogrisico-status”.

Wil je meer weten over de AI Act?

- Op 27 februari praat ik je in een uur bij in mijn Live Webinar AI Act

- Met het boek AI & Algorithms krijg je praktische uitleg en stappenplannen om direct aan de slag te kunnen

- Teken alvast in (vrijblijvend) voor het aankomende diepgravende boek The Annotated AI Act, dat in april verschijnt

- Op 9 mei kun je onze eendaagse cursus AI Compliance & Governance volgen.

- Echt de diepte ingaan doe je met onze opleiding tot CAICO® AI Compliance Officer

Meer van onze artikelen

-

Blog 22 December 2025

AI AVG

AI AVGAI snelt vooruit, privacy achteruit: wat verandert de Digitale Omnibus aan de AVG?

Lees meer -

Blog 18 December 2025

Data & privacy Wetgeving

Data & privacy WetgevingDigital Omnibus: versoepeling of ondermijning van de AVG?

Lees meer -

Blog 15 December 2025

Intellectueel eigendom Data Act

Intellectueel eigendom Data ActOpen data in, exclusieve rechten uit: wat artikel 43 Data Act betekent voor databanken

Lees meer